Traducimos a continuación el análisis del sistema de cámaras del iPhone 13 Pro que han publicado los autores de la excelente app Halide, por su interés para todos aquellos que quieran comprender mejor cómo funciona y qué problemas acarrea el postprocesado inteligente que Apple aplica a todas las fotos que realizamos con el iPhone.

___

Los octubres son emocionantes en la sede de Halide. Apple lanza nuevos iPhones y seguro que actualizarán las cámaras. Como creadores de una aplicación de cámara, tendemos a echar un vistazo más detenido a estas actualizaciones. Aunque otras revisiones pueden salir inmediatamente y ofrecer una impresión rápida, pasamos mucho tiempo probándolas antes de llegar a nuestro veredicto.

Esto lleva semanas (o este año, meses) después de que hayan salido las primeras revisiones, porque creo en tomarme el tiempo para entender todas las peculiaridades y características. En la era de las cámaras inteligentes, hay más peculiaridades que nunca. La inmersión profunda de este año en lo último y lo mejor de Apple, el iPhone 13 Pro, llevó más tiempo. Tuve que investigar un conjunto particular de peculiaridades.

¿”Peculiaridades”? Esto puede ser algo sorprendente de leer, sobre todo si ya has leído muchas revisiones. La mayoría de las reseñas de teléfonos inteligentes y los sitios web de tecnología enumeran el sistema de cámaras del nuevo iPhone 13 Pro como el mejor del mercado en este momento.

No estoy en desacuerdo.

Pero debo admitir que no hago fotos como la mayoría de la gente. Un usuario medio de iPhone toma una foto en la aplicación Cámara de Apple, y… yo trabajo en mi propia aplicación de cámara. Así que tomo fotos tanto en la aplicación de Apple como en la nuestra, y eso me permite hacer algo que Apple no puede: hacer fotos RAW nativas.

Estas fotos me permiten profundizar y curiosear en la foto sin procesar que ha tomado el hardware directamente. Mirando los datos sin procesar, he llegado a la conclusión de que, si bien Apple ha dado un enorme salto adelante en hardware, se encuentra en una posición complicada en el software.

Índice

La importancia del procesamiento

Cuando tomas una foto en un iPhone moderno, o en cualquier teléfono inteligente, te gustaría que lo que veías es lo que se ha capturado, pero nada podría estar más lejos de la verdad.

Los ceros y los unos que ve tu sensor no significarían nada para el ojo humano. Requieren interpretación. Por ejemplo, algunos de los colores que ve la cámara no se pueden representar en la pantalla, por lo que necesita encontrar algo cercano. Algunos bits de procesamiento son creativos, como añadir contraste para hacer que las cosas “resalten”, mientras que otras decisiones son compensar las debilidades del hardware, como el ruido.

Fíjate en esta foto del iPhone poco procesada:

Esta imagen con todo ese ruido no se ha hecho con un iPhone 5, sino con un iPhone 13 Pro. Esta imagen, que es una captura “raw”, es mucho más ruidosa de lo que obtendrías usando una cámara fotográfica de tamaño normal. ¿Por qué? Física.

Mira esta serie que muestra la evolución de las cámaras de Canon a lo largo de más de medio siglo:

Notarás que, si bien las tecnologías van y vienen, e incluso el medio cambia (esta cámara, aunque externamente similar, pasó de la película de 35 mm a la digital), la cámara se mantuvo en una forma similar y, lo más importante, en su tamaño.

La tecnología siempre tiende a la miniaturización. El iPhone es como es gracias a chips más pequeños y densos con más potencia que los grandes ordenadores de escritorio de hace décadas; la pantalla del iPhone tiene una resolución más alta que la mayoría de los televisores, pero encerrado en un tamaño de 5 pulgadas, y la cámara del iPhone también tiene solo una fracción del tamaño de una cámara digital de años anteriores.

Desafortunadamente, las cámaras están limitadas por las leyes de la física. Una lente más grande puede recoger más luz y producir una “profundidad de campo” que nos parece atractiva en el retrato.

Un sensor más grande significa menos ruido y más detalles. Una verdad inconveniente de la fotografía telefónica es que es imposible hacer que la cámara sea más pequeña sin perder calidad.

Pero los teléfonos inteligentes tienen una poderosa ventaja sobre sus hermanos mayores: la magia del procesamiento. Hoy en día, la investigación más vanguardista (incluida la nuestra en Halide) en fotografía se encuentra en un área llamada Fotografía Computacional.

Poner la “inteligencia” en la fotografía de los teléfonos inteligentes

Alrededor de la época de iOS 4 (sí, hace doce años), Apple introdujo una opción “HDR” en su aplicación de cámara para abordar los desafíos técnicos más comunes en la fotografía: capturar cosas realmente brillantes y muy oscuras al mismo tiempo.

Al tomar una foto, las nubes en el cielo se ponen tan brillantes que la cámara solo ve una forma blanca. Si bajas ese brillo, las sombras se volverán negras, perdiendo detalles. Mientras que el ojo humano puede ver tanto las nubes como las sombras al mismo tiempo, el sensor de un iPhone 4 tiene menos “rango dinámico”.

De hecho, este problema de “alto rango dinámico” ha existido desde los primeros días de la fotografía. Los fotógrafos experimentados se ocuparon de ello tomando varias fotos de diferentes exposiciones y parcheándolas juntas. iOS 4 lo resolvió con un modo HDR que podías activar y desactivar. Este interruptor era importante porque…

Las ediciones automáticas de las fotos pueden salir mal. Cuando hay objetos en movimiento, la “fusión” de fotos crea artefactos, o “fantasmas”. Todo esto funcionó con algoritmos más inteligentes, chips más potentes, memoria más rápida y un iPhone que simplemente podía tomar fotos tan rápido que había menos huecos en las fotos.

Avanzamos rápidamente hasta hoy, y tu iPhone va mucho más allá del HDR. No hay una configuración que puedas activar o desactivar durante un tiempo. Cuando haces una foto ahora, la cámara del iPhone fusionará muchas tomas para obtener tu resultado final. Hoy en día, tu cámara siempre “edita” tus fotos por ti. Y exactamente cómo los edita… es un misterio.

Apple, famosa por su secreto, no divulga su salsa secreta para la edición. Sabemos que ilumina las caras mientras conserva su textura, suaviza el cielo y resalta el color y la claridad en el paisaje, y con poca luz, puede suavizar el ruido mientras mantiene intactos los detalles de un suéter. Es un milagro de ingeniería, llevado a cabo en un abrir y cerrar de ojos, gracias a los chips internos optimizados para estos procesos.

Es seguro decir que la mayoría de los usuarios de cámaras se benefician de esto. Si bien estas “ediciones” pueden ser realizadas por fotógrafos experimentados, los fotógrafos experimentados representan menos del 1 % de los usuarios de iPhone.

En la práctica, eso significa que estas ediciones forman parte de la cámara. Para revisar la cámara de un iPhone para la mayoría de las personas, los procesos computacionales son tan importantes (si no más importantes) de evaluar como el hardware.

¿Qué es una cámara?

Y con eso, puedes ver por qué es cada vez más importante definir a qué nos referimos cuando hablamos de una “cámara”.

Si hablo de la cámara que sostienes, podría estar hablando del hardware físico, el objetivo, el sensor y su software operativo básico en el caso de una cámara digital, o podría estar hablando del paquete. El hardware con su software avanzado de hiperprocesamiento de fusión de imágenes.

Las cámaras de los teléfonos inteligentes realmente deberían ser juzgadas por ese paquete. El software se ha convertido en una parte tan desproporcionada de la calidad de imagen que ya no podemos separar las dos; si lo hacemos, la información resultante suele ser incompleta.

Pero no es puramente cualitativo: elegir una lente o un tipo de material de película puede ser una opción creativa. Con los teléfonos inteligentes, elegir si confiar o no en la magia computacional o no también se está convirtiendo rápidamente en una elección creativa.

Si bien todas las fotos de esta revisión provienen de un iPhone 13 Pro, y los resultados parecen incluso mejores que todas las generaciones anteriores, solo algunas de estas fotos omiten el procesamiento del software Camera de Apple.

A medida que el software comience a tomar más y más decisiones creativas por nosotros, y no nos permiten renunciar a usarlo, deberíamos juzgarlo tan críticamente como lo haríamos con cualquier otro componente de la cámara. Y eso es exactamente lo que haré en esta revisión.

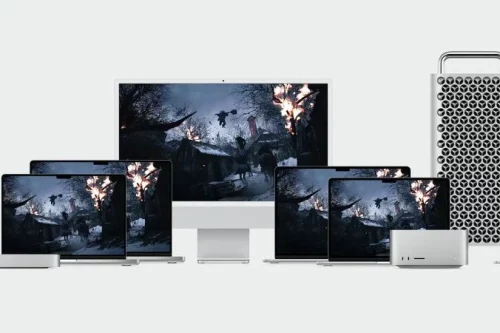

Los cambios

El iPhone 13 Pro de este año vio mejoras en cada bit del hardware de la cámara, excepto en la cámara frontal (también conocida como selfie). Abordémoslos uno por uno.

La cámara de 26 mm de gran angular

La cámara principal del iPhone, o “gran angular”, tiene un sensor más grande y una lente “más rápida”, lo que significa que deja entrar más luz. Esto permite disparos con menos ruido en ambientes de poca luz, incluso antes de que el sistema aplique su procesamiento.

Su gran angular sigue siendo el más versátil, por lo que tiene sentido que sea la cámara de referencia para la mayoría de las tomas. Por lo tanto, es razonable que Apple siga invirtiendo en convertirla en la mejor cámara de la matriz. Cada generación de iPhone lo ve mejorar.

Aquí hay algunas comparaciones con las generaciones anteriores: el iPhone X, el 11 Pro y el 13 Pro. Disparé en RAW “nativo”, que no aplica ningún procesamiento inteligente, y recorté para resaltar los detalles.

Es más difícil distinguir los detalles del iPhone X, ya que muestra mucho más ruido. Si bien el salto de la X al 11 es notable, el paso al 13 Pro lo es mucho menor, a pesar de tener una lente más rápida y un sensor más grande. Es posible que haya muchos más detalles que el sensor y la lente puedan resolver, pero realmente no lo podemos decir, posiblemente sea porque la resolución del sensor ha sido de los mismos 12 megapíxeles desde el iPhone 6S, que se lanzó hace siete años.

La resolución de 12 megapíxeles del iPhone no ha sido un factor particularmente limitante para mí, un fotógrafo de iPhone bastante intenso, durante los últimos años, pero podemos empezar a ver rendimientos decrecientes a medida que Apple introduce inversiones tan tremendas en el hardware y el procesamiento de la cámara.

No te sorprendas si el próximo iPhone mejora la resolución, por ejemplo, un sensor de 48 megapíxeles. Tal vez una de las razones por las que Apple ha aguantado es que tal aumento en la resolución requeriría 4 veces la potencia de procesamiento para realizar la misma magia computacional. Son muchos más datos que procesar en un abrir y cerrar de ojos.

La cámara ultra gran angular de 13 mm

El iPhone 11 de 2019 añadió un nuevo truco a nuestra bolsa de cámara: la cámara ultraancha. Su campo de visión súper ancho similar a GoPro permite capturas dramáticas y nos salva de decisiones difíciles en torno a lo que se recorta en una toma.

El mayor desafío y compensación en las cámaras ultraancha es la distorsión. A medida que la imagen llega a los bordes del marco, las líneas comienzan a curvarse, distorsionando la geometría y las formas. La mayoría está familiarizada con las llamadas lentes de “ojo de pez”: producen imágenes muy “redondas”.

El ultraancho en el iPhone todavía produce una toma “cuadrada”, pero en los bordes las cosas pueden empezar a verse… un poco raras:

El postprocesamiento produce una imagen menos distorsionada, pero a veces puede que disfrutes del efecto. Poco después del lanzamiento del iPhone 11, los retoques encontraron una manera de desactivar estas correcciones para ver cómo se ve la imagen antes de procesarla:

Este ejemplo extremo muestra la importancia de las correcciones de lentes ultraancha. Esta cámara depende más del procesamiento que cualquiera de las otras cámaras para producir imágenes utilizables.

En el iPhone 11 y 12, me pareció útil tener el ultraancho en el bolsillo, mucho más útil que el modo panorámico del iPhone, pero aún así lo evité en su mayoría. Era un “enfoque fijo”, lo que significa que no hay forma de que la lente ajuste lo que es nítido. Fue diseñado para que todo el marco estuviera enfocado. Esto causó imágenes ardientas, intercambiando claridad por un campo de visión más amplio. Nunca sentí que produjera grandes tomas, especialmente en comparación con la excelente cámara gran angular.

El iPhone 13 Pro aborda todo esto. Sin exagerar, este podría ser el salto más significativo en una cámara de iPhone desde que el iPhone 3GS añadió vídeo.

El sensor ultraancho es significativamente más grande, la apertura de la lente es mucho más ancha, ¡y la lente ahora puede cambiar de enfoque! Sigue siendo un sensor más pequeño que en el Wide, y todavía distorsiona y suaviza una imagen en los bordes, pero en general, crea tomas espectaculares con una nitidez bastante buena. Esta no es una mera actualización, se trata de una cámara completamente nueva.

Puedes tomar una foto desde tu punto de vista e incluso meter las piernas en él, y se verá nítida:

Gracias a tener una profundidad de campo real, ahora puedes separar a tu sujeto de su fondo. Su sensor más grande y su apertura más rápida te dan un desenfoque de fondo real (“bokeh”) sin necesidad del modo Retrato.

Ah, y ese enfoque ajustable desbloquea una nueva superpotencia…

Macro

Una ventaja adicional que obtuvimos gracias a la capacidad de la cámara de alterar su enfoque es una extraña distancia límite de enfoque cercano. Este nuevo módulo de cámara puede llegar hasta aproximadamente media pulgada de un sujeto y aún así hacerlo nítido.

Si bien esto permite increíbles perspectivas frescas sobre el mundo, es aún más genial cuando se le aplica algo de magia. Una cosa es una cosa que tenga capacidad macro, pero como desarrollador de aplicaciones de cámara no pudimos evitar llevarla un poco más lejos. Cuando lanzamos una actualización de nuestra aplicación con control de enfoque de grano fino y ampliación de IA, descubrimos que también se puede aplicar a esta cámara ya macrocapaz, creando una especie de microscopio:

Este nuevo paquete de cámara es extremadamente potente, y tiene un potencial increíble con el procesamiento inteligente, como mostramos aquí con una función como Neural Macro.

Esto parece un golpe de una actualización de la cámara, sin embargo, la mayoría de los revisores se encontraron con problemas con esta cámara. Y el problema que tenían era que la cámara era “inteligente”.

Con el interruptor

Podemos concluir que este iPhone incluye un conjunto de cámaras enormemente potente en sus cámaras gran angular y ultraancha, pero para su usuario promedio, solo hay una cámara; aquella con la que disparan. La experiencia de la cámara del iPhone está inteligentemente diseñada de esta manera: fue cuidadosamente diseñada para eliminar la complejidad de una configuración tradicional de fotografía multilente.

Como fotógrafo experimentado, si empaco tres lentes para mi cámara grande, voy a elegir conscientemente entre ellos. Pienso en las compensaciones entre cada lente, como la borrosidad del borde frente al campo de visión. La aplicación de cámara del iPhone quiere tomar esa decisión por ti. No abres la cámara del iPhone y eliges una lente; solo funciona. El iPhone elegirá una lente, aunque no lo hagas. E incluso puede cambiar entre ellos, elijas… o no.

Cuando este cambio inteligente funciona, es como magia. La cámara se comporta y funciona mejor que un conjunto de cámaras separadas. No eliges entre ellos*; la aplicación Cámara se ha programado con un increíble ajuste inteligente para cambiar “sin problemas” entre ellos. Así es como puedes hacer zoom con esta gran rueda desde un objetivo de 13 mm hasta un objetivo de 75 mm:

Hay dos formas en que esto puede funcionar: puede funcionar como verdadera magia, donde la cámara se comportará y funcionará mejor que un conjunto de cámaras separadas, y hay momentos en los que esto puede confundirse con su cambio “inteligente”, creando una transición discordante cuando los usuarios no tienen idea de por qué está sucediendo.

Por ejemplo, en iPhones anteriores con sistemas de cámara dual, cada cámara tenía limitaciones de enfoque. Tu objetivo gran angular (1×) podría enfocar más cerca que el teleobjetivo (2×). Así que si intentaste tomar una foto de algo bastante cercano, el iPhone siempre tomaba la foto con la lente gran angular y recortaba, incluso si habías elegido 2× en la aplicación. Es difícil discutir con esta decisión, ya que es mejor tener una foto de menor resolución que una desenfocada.

Pero también confundió a los usuarios de Halide que escribieron para preguntar por qué no podemos centrarnos en objetos tan cercanos como la cámara de origen. Si realmente fuerza una lente, descubrirá que tiene limitaciones. Tuvimos que darles la noticia, como los padres con hijos mayores hablando de Papá Noel: ese “teleobjetivo de enfoque cercano” no era real. Cubre la cámara de teleobjetivo con el dedo y descubrirás que todavía funcionaba de alguna manera. ¿Qué era esta magia oscura?

Era una cámara inventada que Apple creó virtualmente para engañarnos a todos.

Fun to test it yourself: cover the bottom (telephoto) lens and see when your viewfinder goes black. It might surprise you! pic.twitter.com/mGsLgM5FTW

— Sebastiaan de With (@sdw) April 11, 2018

Y eso nos lleva a esa pequeña “Macro-gate”. Anteriormente, nunca tenía sentido cambiar a esa cámara ultra gran angular. Ahora que puede, varias personas tuitearon y muchos críticos se quedaron desconcertados al ver su cámara saltar erráticamente cuando se enfocaban cerca entre puntos de vista:

Las cámaras de la parte trasera del teléfono están muy espaciadas entre sí, y cuando se centran en algo cercano, cambiar entre ellas crea un “salto” en la imagen. Esto no se puede arreglar fácilmente con software o recorte; es un concepto conocido como paralaje. Si te miras la nariz y cierras uno de tus ojos, y luego el otro, puedes ver tu nariz saltando. La ilusión de la “una cámara” está rota, y ninguna cantidad de procesamiento puede solucionar esto.

La fuente de fricción aquí es que los usuarios saben lo que quieren, pero en una interfaz ultrasimple los “inteligentes” del procesamiento de imágenes y la selección de cámaras tienen que predecirlo. Si el sistema asume correctamente, genial. Pero cuanto más complejo se vuelve este sistema, más te encuentras con momentos en los que una transición sin problemas puede empezar a sentirse como una elección que se está haciendo en tu nombre.

En Halide, simplemente tenemos un modo Macro. Lo cambias para saltar a la lente de enfoque más cercana (y también lanzamos algo de magia de mejora de la IA). Apple evita este tipo de complejidad en su aplicación de cámara, pero cedió en una actualización de iOS 15, lo que la convierte en un ajuste.

No nos malinterpretes: seguimos pensando que su objetivo, el cambio mágico y transparente, es el mejor para casi todos los usuarios. Pero Apple se encuentra con un desafío poco envidiable: una aplicación de cámara que funciona para usuarios de todos los niveles de habilidad. Diseñamos Halide para servir a fotógrafos un poco más experimentados, hasta profesionales experimentados. Apple quiere servir a toda la población de la Tierra, desde los profesionales hasta los padres. Esto requiere una “magia” mucho más avanzada para cerrar estas brechas.

Desafortunadamente, este es un lugar donde la ilusión “mágica” fracasó y en su lugar comenzó a interponerse en el camino del usuario.

La cámara con teleobjetivo de 75 mm

Y eso nos lleva a la cámara final y a mi favorita personal: la cámara de teleobjetivo. Introducido en el iPhone 7 Plus, el teleobjetivo siempre fue una forma fantástica de obtener una toma más cercana desde la distancia, y las distancias focales más largas son particularmente excelentes para retratos y fotografía artística.

Apple dio un pequeño paso a este gran salto en el iPhone 13 Pro con el iPhone 12 Pro Max del año pasado. En lugar de su hermano más pequeño de 12 Pro, el Pro Max venía con un teleobjetivo de 2,5x (equivalente a 65 mm), sacrificando un poco de luz para un poco de alcance. Aunque me gustó, me pareció incómodo en general. No fue suficiente alcance para que lo disfrutara de verdad, y eché de menos tener la nitidez extra a 2x. El escalón era demasiado pequeño.

No más medias medidas: el iPhone 13 Pro y su hermano mayor, el iPhone 13 Pro Max, tienen 3x (77 mm). Desafortunadamente, sin embargo, Apple no bendijo esta cámara con la actualización de todas las demás cámaras. Su sensor sigue siendo decepcionantemente del mismo tamaño. Este es un problema grave.

Prácticamente todos los teleobjetivos hacen un serio sacrificio: la luz. Por ejemplo, en el iPhone 12 Pro, el objetivo gran angular tenía una apertura de ƒ/1,6, su teleobjetivo tenía una ƒ/2.0 más estrecha, lo que permitía la entrada de menos luz. Menos luz se traduce en más ruido y/o desenfoque de movimiento, lo que dificulta obtener una toma afilada.

Este año, esta brecha es aún mayor. La cámara gran angular del iPhone 13 Pro tiene una apertura de ƒ/1.5, mientras que el teleobjetivo tiene una ƒ/2.8, para obtener aún menos luz.

Lo que esto significa es que la cámara que carecía un poco en términos de claridad, ruido y nitidez en los iPhones anteriores ha empeorado… un poco.

Sí, la compensación fue clara: nos ponemos al alcance. A plena luz del día, obtienes algunos disparos fantásticamente nítidos que antes simplemente no podías obtener.

Esta es la naturaleza de los objetivos zoom y las velocidades de obturación. Cuando disparas con dispositivo de mano, cuanto más haces zoom, más susceptible eres al desenfoque de movimiento debido a los sutiles movimientos de tu brazo que sostiene el teléfono. Como regla general, al disparar con dispositivo de mano, debes establecer su velocidad de obturación en el doble de la distancia focal de la lente.

La cámara teleobjetivo del iPhone 12 Pro Max tenía una distancia focal de 65 mm, por lo que las matemáticas funcionaron hasta la 1/130 de segundo. Con el iPhone 13 Pro de 77 m, eso funciona hasta el 1/144o de segundo. Para que te hagas una idea, eso es tres veces más que la cámara gran angular “normal”.

1/144 de segundo también es menos tiempo para exponer o dejar entrar la luz. Menos luz hace que sea difícil conseguir una gran oportunidad.

El iPhone tiene una herramienta para ayudarle a conseguir la inyección en ese corto momento. Puede hacer que el sensor de su cámara sea más sensible. Lo que termina sucediendo es que tu iPhone necesita aumentar su nivel ISO, lo que se traduce en más ruido. Eso significa que el procesamiento posterior del iPhone va a incluir más reducción de ruido que nunca, porque las tomas tienen mucho ruido:

En mis pruebas, introduce mucho más ruido que los iPhones que vinieron antes.

Una regresión en la calidad del ruido entre iPhone no es nueva. Ha habido generaciones de cámaras del iPhone con un procesamiento pesado y notable: el iPhone XS tuvo notablemente algunas reacciones confusas en el lanzamiento de personas que pensaban que su piel estaba siendo suavizada por el nuevo proceso Smart HDR, cuando en realidad solo estaba fusionando imágenes para una mejor toma. ¿La razón del suavizado excesivo? Las cámaras estaban produciendo mejores tomas, pero con más ruido. El aumento del procesamiento por disparo requería más exposiciones, y la única forma de capturar disparos adicionales era con más sensibilidad.

Este fenómeno ha vuelto en el iPhone 13 Pro. Esta vez, tu cámara aplica un “filtro de belleza” a las hojas de un árbol.

Para empeorar las cosas, el cambio transparente entre las cámaras vuelve a levantar la cabeza una vez más aquí. Como la cámara de teleobjetivo es mucho menos sensible a la luz, la aplicación Cámara es muy conservadora a la hora de evaluar cuándo su imagen es lo suficientemente clara como para ser utilizable.

Eso significa que muchas tomas, incluso a la luz del día, en realidad provienen de la cámara ancha (1×) y luego se recortan con la aplicación de la cámara.

Si bien hay una cantidad admirable de detalles recuperados aquí, la segunda toma aquí no la ha hecho mi teleobjetivo, es solo una toma de la lente gran angular normal, elegida porque la falta de luz por la noche hace que el teleobjetivo sea menos utilizable para tomas rápidas

Este problema se ve agravado por la mayor diferencia en la distancia focal entre las cámaras de gran angular y de teleobjetivo. En años anteriores, solo pasaba de 1× a 2×. Ahora, el sistema se cultiva en un factor de 3×. Ahora considera que el recuento de megapíxeles no está empujando exactamente los límites, cuando lo recortas tanto, terminas con, bueno…

Apple está haciendo algunas cosas divertidas para evitar la pixelación. En la imagen de arriba, “rellena” bastante bien los detalles del texto del signo de límite de velocidad, manteniéndolo legible. Otras áreas, sin embargo, se modifican de maneras aparentemente extrañas, incluso haciendo que los cables de suspensión del puente desaparezcan alrededor de las farolas por razones inexplicables:

Aquí es donde me encuentro con un problema frecuente con el 13 Pro. Su complejo conjunto entrelazado de componentes de software “inteligentes” no encajan bien. La cámara panorámica excelente pero limitada en megapíxeles intenta “ocultar” el cambio a la cámara de teleobjetivo, creando una imagen ahumorizada. La ampliación inteligente del software está interviniendo para que la imagen se vea menos pixel-y, lo que altera significativamente el aspecto de la imagen: se asemeja más a una pintura que a una fotografía cuando se explota.

Al cambiar de lente, tengo que esperar que la cámara cambie a la cámara de teleobjetivo real, pero si el sensor no puede recoger suficiente luz, la imagen sufre de un aspecto “sobreprocesado”. La imagen es un recorte mejorado de la cámara gran angular o un fotograma muy reducido en ruido del sensor de teleobjetivo.

Soy un gran fan de esta foto que tomé con la cámara de teleobjetivo:

Sin embargo, muchas personas en Twitter opinaron que parecía una “pintura”.

Puedo ver por qué: en esta escena con poca luz, la imagen del teleobjetivo se está suavizando mucho. Tengo que dar un gran apoyo a la cantidad de detalles que se conservan y se mejoran, pero la imagen termina pareciendo antinatural. Centrarse en los detalles hace que la imagen se vea un poco demasiado manchada:

Compara esto con una imagen RAW pura (no procesada en la cámara) de la misma cámara de teleobjetivo, y podrás ver por qué Apple hizo esta elección:

Aquí es donde entra el ruido visible en la toma, algo contra lo que la cámara de Apple combate siempre. Personalmente, no me importa tanto. De hecho, creo que en una escena oscura, se suma a la textura, creando una imagen más “realista” que la imagen de lluvia suavizada.

Al final, esta es una elección creativa. Apple está haciendo verdadera magia con su procesamiento; obtiene imágenes muy utilizables y detalladas de un sensor muy pequeño con una lente que simplemente no puede recoger la luz necesaria para grandes imágenes nocturnas de mano. Esto es sin siquiera tener en cuenta el procesamiento salvaje que permite el modo nocturno. Sin embargo, si eres fotógrafo, debes estar al tanto de este procesamiento y tomar una decisión informada si quieres usarlo o no.

Me he decidido después de unos meses: para mí, el procesamiento del iPhone en el iPhone 13 Pro es simplemente demasiado extremo a veces.

He depurado mis prioridades: con luz de día, a menudo dispararé con nuestra aplicación de cámara configurada en RAW nativa. Disparar de esta manera omitirá la mayor parte de la reducción agresiva de ruido y la mejora de los detalles que están omnipresentes en las fotos del iPhone 13 Pro. El ligero grano me atrae, y disfruto de la “apariencia procesada” ligeramente menos. Por la noche, optaré por la magia que me ayuda a obtener grandes fotos en la oscuridad: modo Noche, reducción de ruido ProRAW y mejora de los detalles.

Ser consciente de la magia de la fotografía computacional me ayuda a apreciarla mucho más.

Como mencioné anteriormente, la elección creativa más importante que tendremos que empezar a tomar como fotógrafos es elegir la cantidad de procesamiento de nuestras imágenes por parte de nuestras cámaras. Si podemos tomar esa decisión, al menos. A veces, la elección se hace por ti.

Un último ejemplo de cómo es difícil evitar el procesamiento computacional del iPhone:

Desde el iPhone 12 Pro, Apple ha introducido su propio formato RAW para las tomas. Anteriormente, tomar fotos RAW significaba que perdiste toda la magia y el potente procesamiento de imágenes de Apple: las fotos a menudo requerían mucha edición cuando se tomaban en RAW vs. JPG. Las imágenes eran ruidosas y carecían de rango dinámico; después de todo, en las tomas JPG regulares, los reflejos y las sombras se resaltaban al tomar múltiples exposiciones. Habilitar ProRAW ofrece a los usuarios una forma de obtener este procesamiento inteligente, con toda la flexibilidad y la calidad de imagen de un archivo RAW.

Desafortunadamente, no permite *pasar* de parte de este procesamiento. Mi mayor problema es no poder optar por no reducir el ruido, pero en el iPhone 13 Pro hay un problema mucho mayor. Incluso si habilita ProRAW en la cámara de origen, cambiar de lente en la aplicación Cámara de Apple no significa que realmente cambie a la cámara adecuada. Varias tomas que capturé en modo teleobjetivo dieron como resultado una imagen recortada de ProRAW procedente de la lente equivocada:

Sí, lo sé: este no es un problema exclusivo del iPhone. El Google Pixel también cambia opacamente entre cámaras cuando lo considera necesario, ofreciendo tan poco como un recorte de 0,3 megapíxeles de otra cámara incluso cuando se dispara en “RAW”.

La única solución, aparte de usar una aplicación como Halide, es vigilar de cerca su visor después de cambiar de sujeto, para ver si la cámara ha cambiado. Desafortunadamente, esto puede tardar hasta varios segundos.

Encontramos que esto cruza una frontera que la fotografía computacional no debería cruzar en un contexto profesional. La captura RAW debe ser explícita, no una sorpresa. En un formato de captura RAW, la cámara debe respetar la intención del usuario y la elección creativa. Si el usuario elige una lente, incluso la lente “equivocada”, el software debe usar esa lente. Si la “cámara” considera que eso es un error, no quiero que me impida tomar la foto. Quiero cometer mis propios errores. Como dicen: la creatividad es permitirte cometer errores. El arte es saber cuáles conservar.

Entiendo que la cámara de la primera fiesta no está pensada para profesionales, y todavía puedes sacar fotos geniales de esta cámara. Sigo creyendo que Apple está en un lugar difícil: la aplicación Cámara tiene que funcionar para todos los usuarios de iPhone, desde el principiante hasta el fotógrafo experimentado con décadas de experiencia.

Hay una paradoja en la relación entre hardware y software: es fácil hacer software más inteligente con hardware defectuoso. Las decisiones son en blanco y negro. Pero a medida que el hardware se vuelve más sofisticado, las decisiones implican más tonos de gris. ¿Cómo puede la ciencia cuantificar un nivel aceptable de ruido o desenfoque de movimiento, cuando gran parte de esto depende de la intención artística de cada foto? A medida que crece la complejidad de la fotografía computacional, también crece su dominio sobre nuestras decisiones creativas, y me encuentro cada vez más en desacuerdo con las decisiones que toma.

Creo que a medida que esta tendencia continúa, elegir qué nivel de procesamiento de software para permitir los datos de su cámara se convertirá cada vez más en la opción creativa más importante en la fotografía.

Pensamientos finales

El iPhone 13 Pro es un gran cambio en la fotografía del iPhone. No solo las cámaras se actualizan de manera significativa, sino que la inteligencia computacional adaptativa e inteligente de Apple nunca ha sido tan potente. Al tocar todos los aspectos de la experiencia fotográfica, es posible que te sorprenda que a veces te des cuenta de su poder y sus limitaciones por igual.

Si vienes de un iPhone 12 y no haces muchas fotos, es posible que no veas un salto en la calidad, porque ahora mucho está determinado por el procesamiento existente, que ya era fantástico en la generación anterior. Sin embargo, el iPhone 13 Pro da otros saltos hacia adelante, con mejoras físicas en la cámara ultra gran angular y la cámara con teleobjetivo 3×. Desafortunadamente, ese procesamiento mágico a veces va en contra del hardware.

Si eres un fotógrafo serio, el iPhone 13 Pro es una cámara brillante, y solo empezarás a rayar la superficie de su potencial con su software y procesamiento integrados. Cuando se utilizan aplicaciones como Halide u otras aplicaciones de terceros, las posibilidades realmente comienzan a presentarse. Apple aquí ha sentado las bases; al igual que con el sensor LIDAR que se añadió en el iPhone anterior, las mejoras de la cámara aquí sientan las bases para que el software realice magia.

Lo único que tienes que añadir es tu propia visión creativa.

Muchos más ejemplos sobre las diferentes cámaras en el post original. Todas las imágenes de esta reseña fueron tomadas en el iPhone 13 Pro por Sebastiaan de With.